Cómo optimizar tu contenido para Modelos de Lenguaje: guía práctica sobre tokens, chunks y embeddings

Leer resumen

Los modelos de lenguaje como ChatGPT están transformando el consumo de contenido, exigiendo una nueva estrategia de visibilidad para las marcas que va más allá del SEO tradicional. Para que tu contenido sea citado por estas IA, es crucial entender cómo procesan el lenguaje mediante tokens (unidades mínimas de texto) y chunks (fragmentos de 300-800 tokens que deben ser autónomos y densos en información). Cada modelo tiene un límite de tokens, lo que significa que el contenido largo se procesa en bloques.

La clave radica en la vectorización de tu contenido, que convierte el texto en representaciones numéricas (embeddings) para que los modelos busquen similitudes semánticas entre consultas y tu información. Si tus embeddings se alinean con las preguntas de los usuarios, tu contenido será relevante. Optimizar para LLMs implica priorizar la calidad sobre la cantidad, usar estructuras jerárquicas claras, crear secciones autónomas, definir conceptos antes de desarrollarlos e incorporar fuentes confiables y menciones de marca.

Tabla de contenidos

Los modelos de lenguaje detrás de herramientas como ChatGPT, Perplexity o Grok (GPT-4o, Gemini 1.5 y Claude 3, entre otros) están cambiando la forma en que se consume contenido en Internet.

Para que tu marca sea visible en sus respuestas, no basta con tener buen SEO tradicional: debes entender cómo estos modelos procesan el lenguaje y cómo optimizar tu contenido para eso.

En esta guía te explico cómo funcionan los tokens, los embeddings y qué hacer para que tu contenido sea más útil y citable en la era de la IA generativa.

¿Qué es un Token?

En los modelos de lenguaje, un token es la unidad mínima de texto que el modelo procesa. Puede ser:

- Una palabra entera (ej:

perro) - Una parte de una palabra (ej:

com+iendo) - Un signo de puntuación (ej:

.o,)

Por ejemplo, la frase:

“Los perros comen carne.”

Se tokeniza así:

["Los", " perros", " comen", " carne", "."] → 5 tokens¿Cuántos tokens puede procesar un modelo?

Cada modelo tiene un límite de tokens que puede procesar en total, entre lo que lee (contexto) y lo que genera (respuesta):

| Modelo | Tokens de contexto | Equivalencia estimada |

|---|---|---|

| GPT-3.5 Turbo | 4.096 | ~8 páginas |

| GPT-4 (original) | 8.192 | ~20 páginas |

| GPT-4 Turbo | 128.000 | ~300 páginas |

| Claude 3 Opus | 200.000+ | ~500 páginas |

Esto significa que si tu contenido es muy largo, no se procesa todo junto, sino en bloques.

Considera que la cantidad de tokens procesados incluye tanto tus prompts como lo que responde el modelo en una conversación.

¿Qué es un Chunk?

Un chunk es un fragmento de texto que los modelos de lenguaje dividen internamente para vectorizar y almacenar en su memoria o base de conocimiento.

- Tienen entre 300 y 800 tokens.

- Se procesan independientemente.

- Deben tener sentido completo por sí mismos.

Si un chunk está mal escrito, es irrelevante o está lleno de relleno, se desperdicia espacio semántico.

Mal chunk:

“Desde hace muchos años, el marketing digital ha evolucionado constantemente, presentando desafíos y nuevas oportunidades para los profesionales del área. En este artículo queremos hablar de un tema que, sin duda, ha cobrado relevancia: el SEO…”

Aunque parece una buena intro para humanos, no dice nada concreto. Para un LLM, es relleno.

Buen chunk:

“El SEO técnico se refiere a todas las optimizaciones que afectan directamente la capacidad de rastreo, indexación y rendimiento de un sitio web. Esto incluye mejoras en velocidad de carga, estructura del sitio, uso de etiquetas, y sitemap XML.”

Directo, útil, comprensible solo, y vectorizable.

Tokens densos en información = mayor posibilidad de ser citados.

¿Qué significa «vectorizar»?

Vectorizar significa convertir un fragmento de texto en una representación numérica (vector) que resume su significado semántico.

Es como transformar palabras en números, pero no números cualquiera: son coordenadas en un espacio matemático, donde textos con significados similares terminan “cerca”.

Por ejemplo, revisemos este párrafo de uno de mis artículos:

Una de las ventajas más destacadas del SoS es su capacidad para predecir cambios en la cuota de mercado con hasta un año de anticipación. Por ejemplo, en categorías como automóviles, se ha observado que las variaciones en el SoS preceden a los cambios en las ventas reales, proporcionando a las marcas una ventana de tiempo valiosa para ajustar estrategias y campañas.

Así se vería un mapa de agrupación semántica:

Qué vemos:

El párrafo aparece muy cerca de textos relacionados con marketing, SoS, cuota de mercado y ventas, lo que indica que su vector se alinea semánticamente con ese grupo.

El texto sobre adiestramiento de perros y el de viajar por Italia aparecen lejos, lo que confirma que sus vectores son diferentes en significado.

¿Qué demuestra esto?

Que el chunk está bien vectorizado: tiene un significado claro, enfocado y se agrupa correctamente con otros conceptos de marketing y análisis.

Esto aumenta la probabilidad de que un modelo como ChatGPT o Perplexity lo identifique como útil para responder preguntas relacionadas con SoS, cuota de mercado o estrategias de marketing.

Pero aún se puede mejorar más:

El indicador SoS (Share of Search) permite anticipar cambios en la cuota de mercado con hasta 12 meses de antelación. En sectores como el automotriz, las variaciones en el SoS han demostrado preceder a las fluctuaciones en las ventas reales. Esto ofrece a las marcas una ventaja competitiva clave: detectar tendencias con anticipación y adaptar sus estrategias de marketing antes que sus competidores.

¿Qué son los Embeddings?

Los embeddings son representaciones vectoriales de texto. Cada chunk se convierte en un vector numérico que representa su significado.

Esto permite a los modelos buscar similitudes entre consultas y contenido. Si el embedding de tu contenido se parece al embedding de una pregunta del usuario, tu chunk podría ser usado para generar la respuesta.

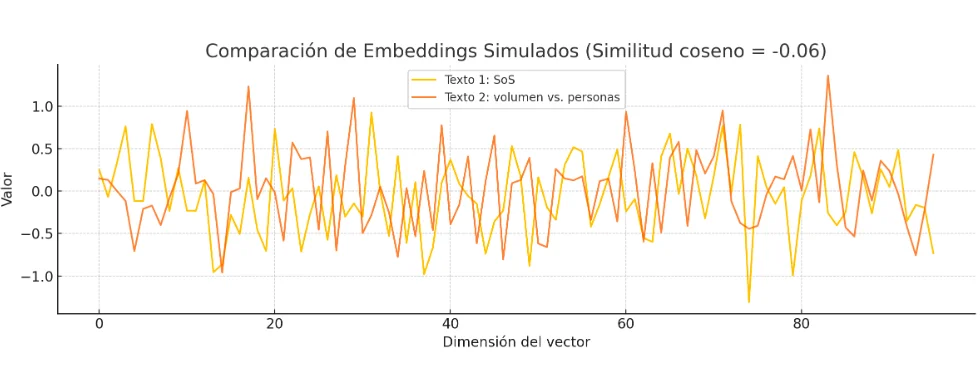

El siguiente gráfico representa una comparación entre dos textos míos de dos posts distintos.

Cada punto del eje X corresponde a una de las 96 dimensiones del vector (en realidad suelen ser 384, 768 o hasta 1536 en modelos reales como text-embedding-ada-002).

¿Qué se interpreta del gráfico?

La similitud coseno entre ambos embeddings es de aproximadamente 0.02, lo que indica que, aunque ambos textos tratan de marketing digital, sus enfoques semánticos son distintos para el modelo.

¿Cuándo consideramos que dos textos están “relacionados”?

En la práctica (con embeddings de OpenAI, Cohere, etc.):

≥ 0.80 → están en el mismo tema, enfoque similar.

≥ 0.60 → están relacionados pero pueden abordar aspectos distintos.

< 0.40 → probablemente hablan de cosas distintas.

En este caso un LLM no los agruparía como sinónimos ni como contenido redundante, lo que es ideal si uno está escribiendo múltiples secciones de un artículo con ideas diferenciadas.

¿Cómo optimizar contenido para ser procesado por LLMs?

Si quieres que tu contenido sea «LLM-friendly», toma en cuenta lo siguiente:

1. Calidad sobre cantidad

Evita párrafos innecesarios. Cada token cuenta: haz que aporte valor.

2. Usa estructuras jerárquicas claras

- Encabezados bien organizados (H2, H3).

- Párrafos cortos (3–5 líneas).

- Listas con viñetas y tablas.

3. Secciones autónomas

Cada sección debe tener sentido por sí sola. Idealmente, cada chunk debe poder responder una pregunta.

4. Define antes de desarrollar

Comienza con una definición o idea clave, luego entrega contexto o ejemplos.

5. Incorpora fuentes y marcas reconocibles

Enlaza a medios o estudios confiables. Menciona tu marca estratégicamente.

¿Por qué importa esto para el SEO del futuro?

Los motores de respuesta como ChatGPT, Claude o Perplexity ya no devuelven 10 enlaces azules. Ofrecen respuestas directas y, a veces, citan fuentes.

Si quieres estar ahí:

- Asegúrate de tener chunks útiles.

- Haz que tu contenido sea vectorizable.

- Responde con precisión lo que alguien buscaría.

Esto no reemplaza al SEO tradicional, pero lo complementa en esta nueva capa de descubrimiento impulsada por IA.

Conclusión

Optimizar tu contenido para modelos de lenguaje no se trata de escribir más, sino de escribir mejor. Cada token cuenta, cada párrafo debe tener un propósito, y cada sección debe estar diseñada para ser útil tanto para un lector humano como para una IA.

Personalmente mi primera impresión cuando estudié el tema, no me gustó, porque me pareció que limita mucho la creatividad y la oportunidad de construir prosas llenas de emoción para contar historias. Pensé: es como escribir un telegrama.

Pero luego sopesé y lo veo como gran desafío: ser conciso, pero a la vez, capaz de contener un mensaje que sea significativo no solo como un chunk para ser citado en modelos de lenguaje, sino para que el lector conecte… (ya creo que me excedí en tokens aquí, je).

En esta nueva etapa del marketing de contenidos, la claridad, la estructura y la relevancia semántica son tus mejores aliados para lograr visibilidad no solo en buscadores, sino también en motores de respuesta.

Francisco Fuentes

También te pueden interesar...

Cómo la inteligencia artificial está cambiando el SEO en medios: resumen de mi charla en la UdeC

El objetivo central de mi charla fue explicar cómo la inteligencia artificial está transformando los resultados de búsqueda en internet y el tráfico hacia los

Cloudflare lanza “Pay Per Crawl”: ¿un salvavidas para la monetización de los medios?

Un nuevo modelo para que los publishers puedan monetizar el acceso de los crawlers de IA, marcando el inicio de una discusión clave sobre sostenibilidad,

Guía SEO para Pymes 2025: cómo generar tráfico web gratuito

Descubre las mejores estrategias y herramientas gratuitas para aumentar las visitas a tu sitio web sin invertir en publicidad. Una guía práctica diseñada especialmente para

8 razones para contratar a un consultor SEO freelance

¿Tu empresa busca maximizar el ROI de su estrategia SEO sin los altos costos de una agencia tradicional? Descubre por qué contratar un consultor SEO

Comparador Semántico Basado en IA: herramienta para análisis de contenido

¿Tu contenido está optimizado tanto para Google como para los motores de respuesta como Chatgpt? Con el objetivo de responder a esas preguntas desarrollé una

Cómo optimizar tu contenido para Modelos de Lenguaje: guía práctica sobre tokens, chunks y Embeddings

Conoce un poco más sobre cómo procesan los contenidos los modelos que usan herramientas como ChatGPT o Gemini. Y sigue las recomendaciones para aumentar tus